Le phénomène Big Data ne cesse de faire

parler de lui. Si certains considèrent que ce n’est qu’un buzz de plus

lancé par les éditeurs pour propulser leurs offres, d’autres s’accordent

à dire qu’il s’agit bien d’une des prochaines évolutions de

l’informatique d’entreprise. Retour sur la matinée 01 Big Data qui a été une très belle occasion d’en savoir plus sur le sujet.

Les matinées 01 sont généralement de bons moments de partage entre intervenants avec un niveau d’expertise relevé. Ce fût une fois de plus le cas ce matin avec la thématique Big Data. J’ai eu l’opportunité de travailler sur le contenu avec José Diz, le journaliste qui animait la matinée, et je suis donc mal placé pour donner un avis objectif mais si j’en crois les retours de ceux avec lesquels j’ai pu échanger l’objectif est atteint.

J’ai retenu également l’exemple de la société Kobojo, une PME française spécialisée dans les jeux pour réseaux sociaux. Un très bon exemple qui démontre bien que Big Data ne concerne pas que les Big entreprises. Comme vous pouvez le voir sur le slide d’Olivier, Kobojo et Big Data c’est 300 à 400 millions de données récoltées et traitées par jour pour adapter l’offre et réagir à la demande.

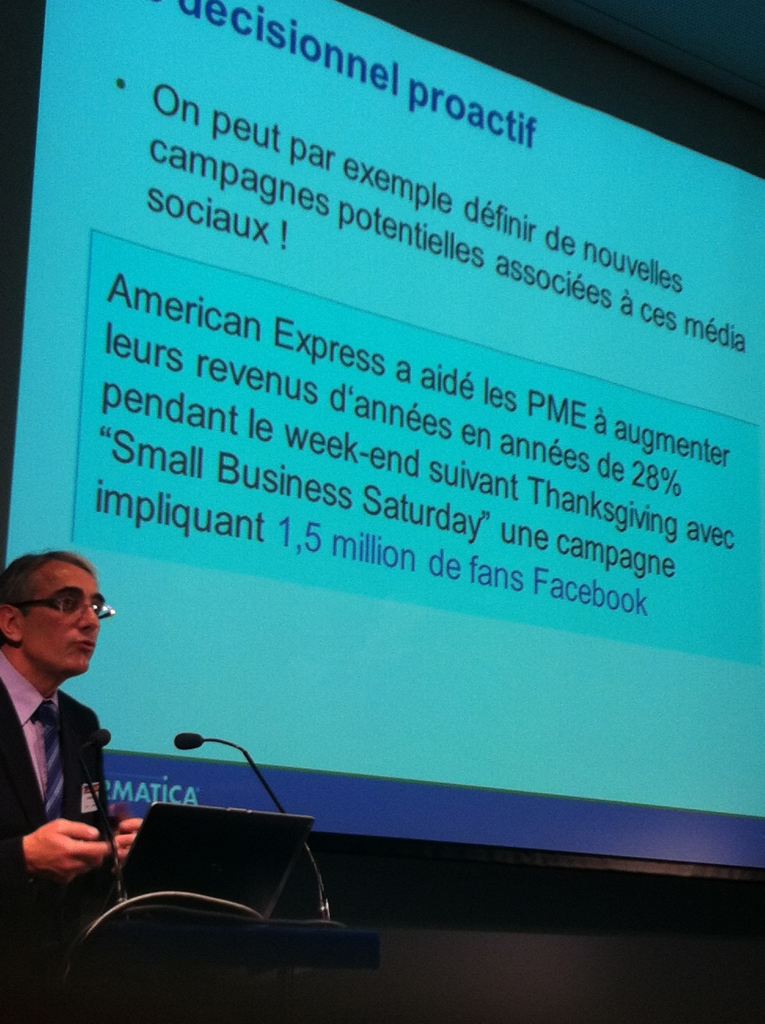

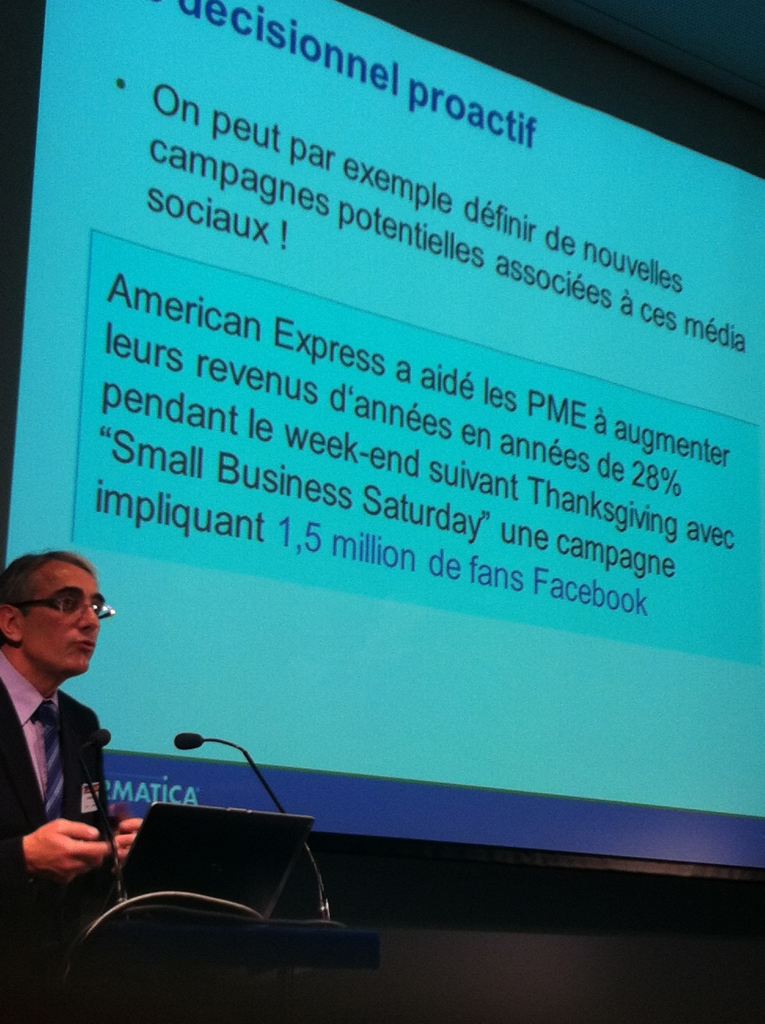

American Express a aidé les PME à augmenter leurs revenus d’années en années de 28% pendant le week-end suivant Thanksgiving avec « Small Business Saturday », une campagne impliquant 1.5 millions de fans Facebook.

En recherche médicale, la recherche sur l’ADN génère 1 To de données par expérimentation et nécessite un fort besoin de traitement analytique. Big Data peut répondre à ces problématiques.

En géologie, un séquenceur pour calcul sismique génère 2 To par run et des millions de fichiers associés qu’il faut prendre en compte, traiter et interpréter. Seul Big Data a la capacité à assurer ces traitements en un temps raisonnable.

Les responsables marketing qui veulent pouvoir faire un mailing bien ciblé à partir des donnes glanées sur les réseaux sociaux comme Facebook peuvent utiliser Big Data pour acquérir, qualifier, traiter et analyser les données.

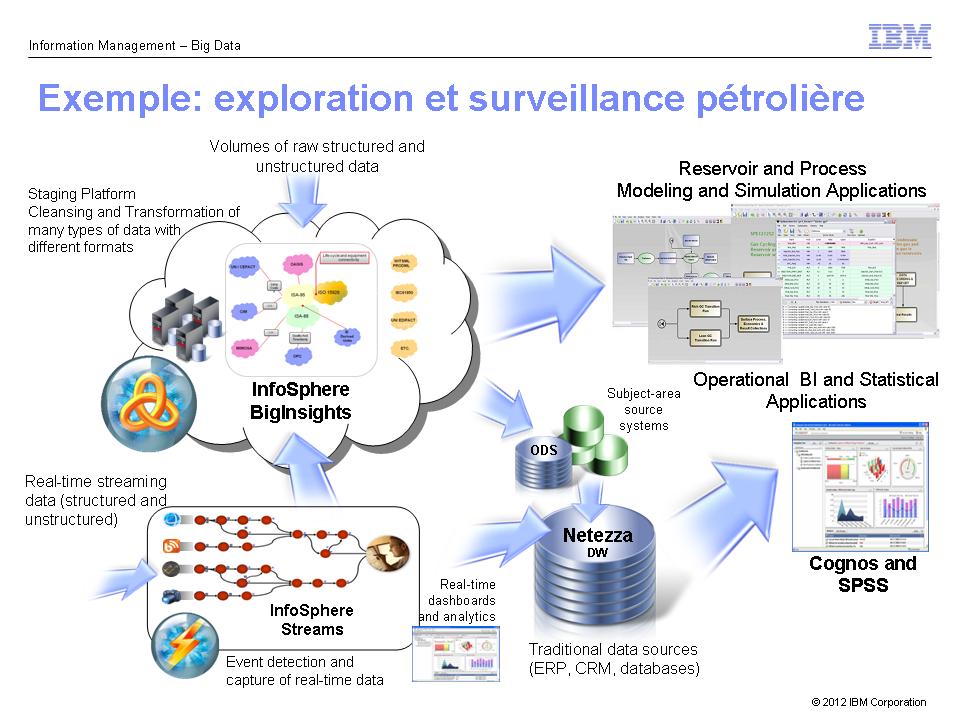

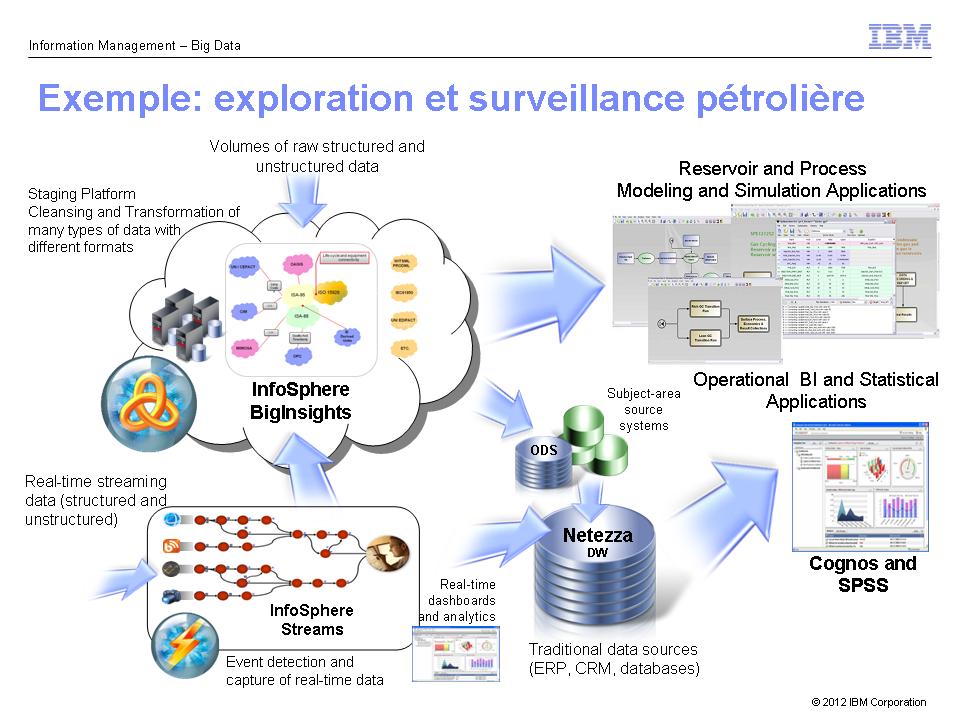

Les compagnies pétrolières doivent assurer exploration et surveillance avec un pilotage temps réel et une détection des problèmes la plus rapide possible. Big Data est capable de prendre en compte les millions d’informations collectées par l’ensemble des capteurs et d’appliquer les patterns de reconnaissance sur le flux de données – Stream.

Les organismes de crédit peuvent coupler un système Hadoop avec un Datawarehouse et un système détection de fraude pour assurer le suivi temps réel des transactions. C’est ce qu’à fait un des clients cités par l’un des intervenants.

Les matinées 01 sont généralement de bons moments de partage entre intervenants avec un niveau d’expertise relevé. Ce fût une fois de plus le cas ce matin avec la thématique Big Data. J’ai eu l’opportunité de travailler sur le contenu avec José Diz, le journaliste qui animait la matinée, et je suis donc mal placé pour donner un avis objectif mais si j’en crois les retours de ceux avec lesquels j’ai pu échanger l’objectif est atteint.

Introduction à Big Data

En introduction à cette matinée Big Data, deux sessions clés : une table ronde permettant aux éditeurs de partager leur vision et les implémentations faites par leurs clients, et la vision de l’analyste, Olivier Rafal de PAC – Pierre Audoin Consultants – qui a très bien positionné le sujet et a su démontrer, s’il le fallait encore, que Big Data n’est pas un simple concept marketing. Il y a bien une réalité métier derrière tout ça, Olivier le décrit mieux que moi. Je retiendrai ce qui apparaissait sur ses slides :

Big Data : les 3V par Olivier Rafal (cliquer que l’image pour la voir en grand)

Big Data adresse les 3V : volume, variété, vélocité de l’information. Big Data répond aux problématiques métiers comme mieux connaître son client, améliorer son offre, agir avant ses concurrents.J’ai retenu également l’exemple de la société Kobojo, une PME française spécialisée dans les jeux pour réseaux sociaux. Un très bon exemple qui démontre bien que Big Data ne concerne pas que les Big entreprises. Comme vous pouvez le voir sur le slide d’Olivier, Kobojo et Big Data c’est 300 à 400 millions de données récoltées et traitées par jour pour adapter l’offre et réagir à la demande.

illustration de Big Data avec le cas Kobojo par Olivier Rafal

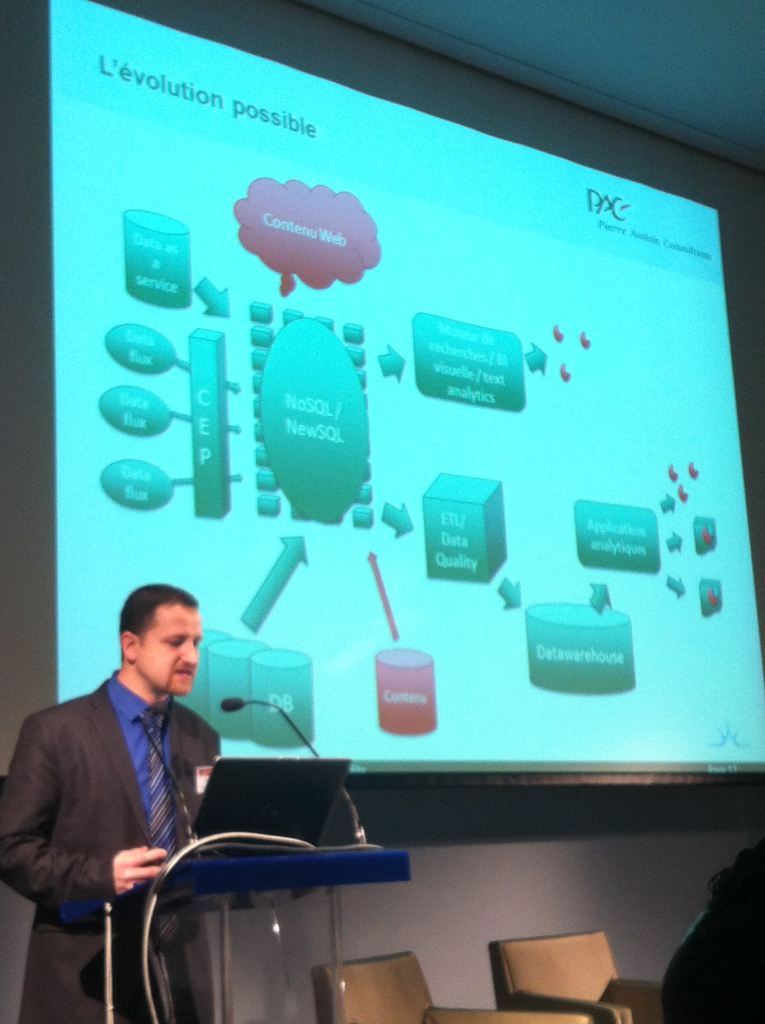

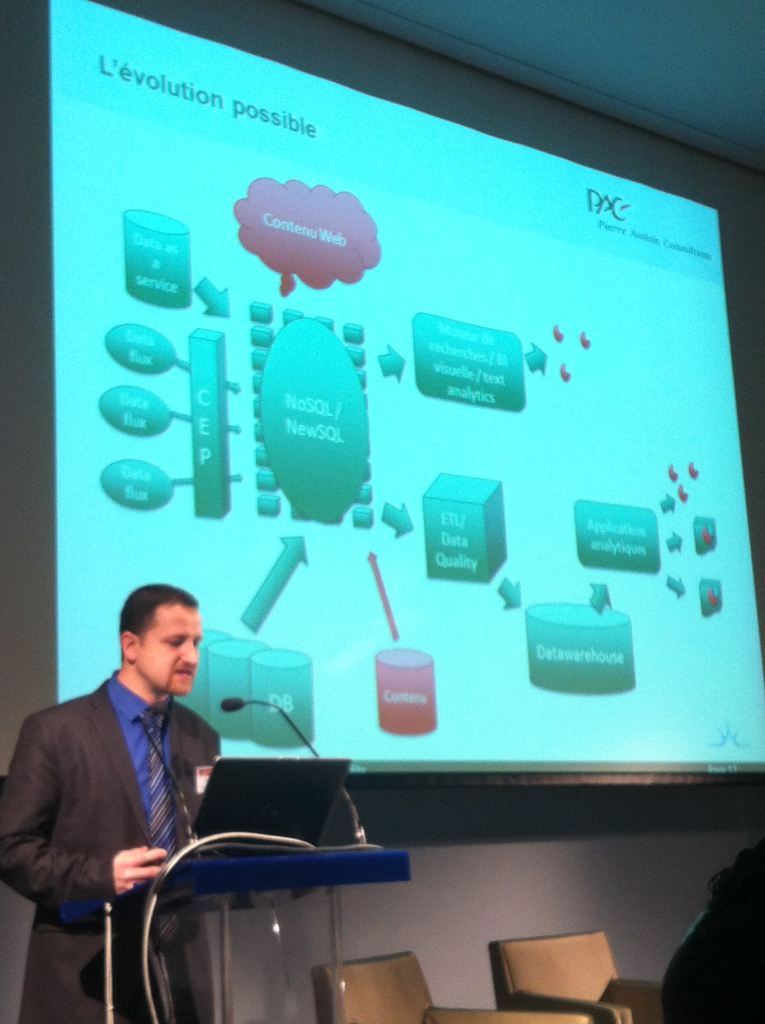

Pour ceux que cela intéresse, notez l’évolution prévisible des architectures de gestion des données :- un lien étroit entre systèmes d’acquisition/traitement des données (via ETL) et datawarehouse,

- alimentation du système d’acquisition par des sources diverses et variées,

- présence d’une brique CEP – Complex Event Processing – pour gérer le flux – Stream,

- mise en retrait des bases SQL et prédominance de briques Hadoop et MapReduce,

- lien entre Datawarehouse et applications analytiques.

Big Data , l’évolution possible selon Olivier Rafal – PAC

A quoi sert Big Data ?

Les différents intervenants ont su montrer des cas d’usages de Big Data qui mettent en évidence le bien fondé du ‘concept’. Voici quelques exemples relevés au fil des interventions :

American Express a aidé les PME à augmenter leurs revenus d’années en années de 28% pendant le week-end suivant Thanksgiving avec « Small Business Saturday », une campagne impliquant 1.5 millions de fans Facebook.

En recherche médicale, la recherche sur l’ADN génère 1 To de données par expérimentation et nécessite un fort besoin de traitement analytique. Big Data peut répondre à ces problématiques.

En géologie, un séquenceur pour calcul sismique génère 2 To par run et des millions de fichiers associés qu’il faut prendre en compte, traiter et interpréter. Seul Big Data a la capacité à assurer ces traitements en un temps raisonnable.

Les responsables marketing qui veulent pouvoir faire un mailing bien ciblé à partir des donnes glanées sur les réseaux sociaux comme Facebook peuvent utiliser Big Data pour acquérir, qualifier, traiter et analyser les données.

Les compagnies pétrolières doivent assurer exploration et surveillance avec un pilotage temps réel et une détection des problèmes la plus rapide possible. Big Data est capable de prendre en compte les millions d’informations collectées par l’ensemble des capteurs et d’appliquer les patterns de reconnaissance sur le flux de données – Stream.

Les organismes de crédit peuvent coupler un système Hadoop avec un Datawarehouse et un système détection de fraude pour assurer le suivi temps réel des transactions. C’est ce qu’à fait un des clients cités par l’un des intervenants.

Pourquoi Big Data et pas les architectures traditionnelles ?

Big Data doit répondre à des problématiques nouvelles, doit apporter

des réponses là où les architectures traditionnelles ne suffisent plus.

Parmi les rôles attribués à Big Data, on trouve :

Quelques chiffres cités en séance positionnent le débat, s’il le fallait. L’humanité, par exemple, produit tous les 2 jours autant de données qu’elle en a produit depuis ses origines jusqu’à 2003. Le Gartner prévoit d’ailleurs une croissance de 800% des quantités de données à traiter d’ici cinq ans.

Les architectures traditionnelles ont donc atteint leurs limites, et il est nécessaire sinon indispensable de les compléter d’une infrastructure Big Data pour continuer à assurer les traitements requis.

De même, s’il est important de disposer de données maîtres qualifiées, gérées, non redondantes pour alimenter son système Big Data, on ne peut se contenter d’une solution MDM – Master Data Management – pour assurer les traitements requis. La briques MDM est une brique à prendre en compte, ce n’est pas la seule.

Pour en savoir plus sur Big Data, je vous recommande vivement la lecture de l’ouvrage intitulé « Understanding Big Data« , offert en libre téléchargement (via formulaire) sur le site d’IBM. Si vous préférez acquérir une version papier : Understanding Big Data chez Amazon pour 18 euros environ.

- l’extraction des données,

- la découverte,

- le nettoyage pour passer des volumes à la pertinence,

- l’intégration au sein d’un système de référencement,

- l’analyse pour dégager de la valeur des données ainsi traitées.

Quelques chiffres cités en séance positionnent le débat, s’il le fallait. L’humanité, par exemple, produit tous les 2 jours autant de données qu’elle en a produit depuis ses origines jusqu’à 2003. Le Gartner prévoit d’ailleurs une croissance de 800% des quantités de données à traiter d’ici cinq ans.

Les architectures traditionnelles ont donc atteint leurs limites, et il est nécessaire sinon indispensable de les compléter d’une infrastructure Big Data pour continuer à assurer les traitements requis.

Comment intégrer Big Data à l’infrastructure existante

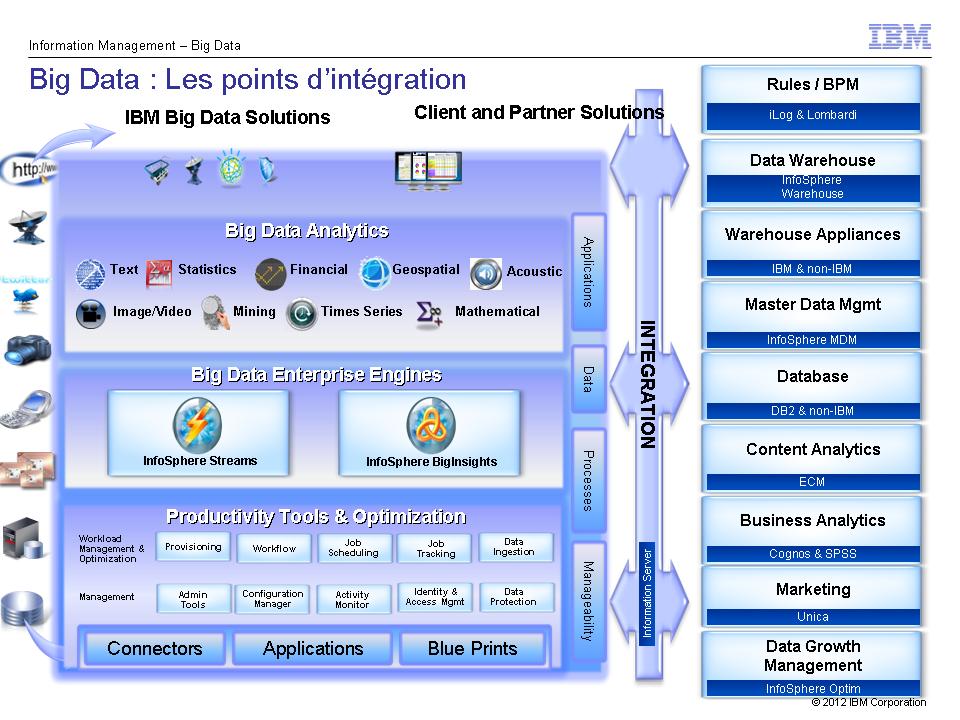

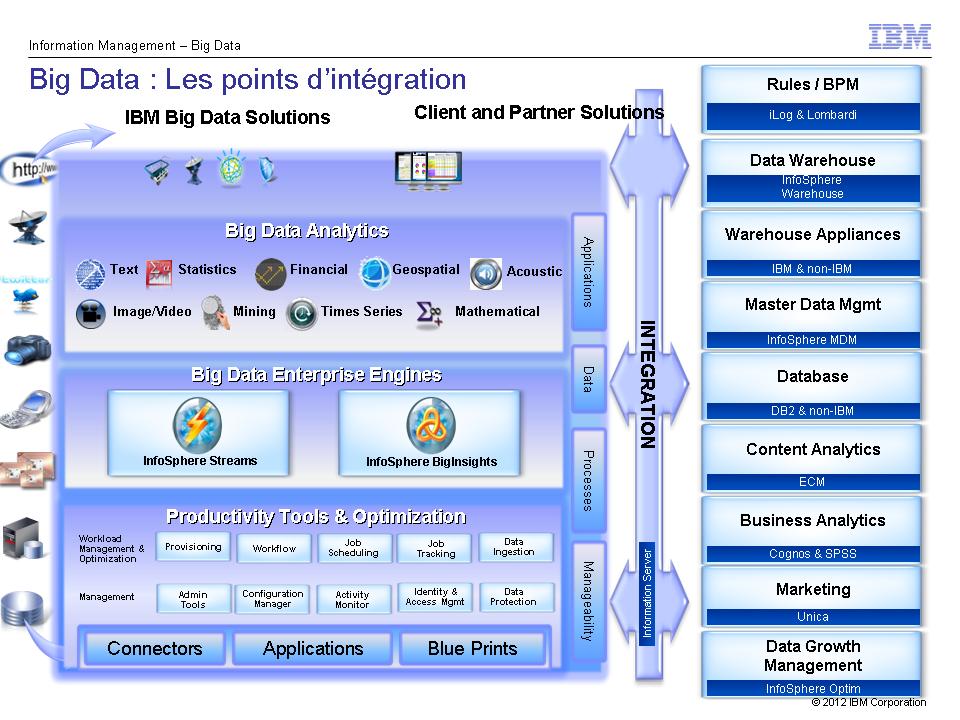

Je m’appuie ici sur le slide d’Isabelle Claverie-Bergé, expert Big Data chez IBM, qui nous a présenté les différents modes d’intégration possible. Si ce slide fait forcément référence à la plateforme Big Data IBM, il n’en reste pas moins suffisamment générique pour donner un aperçu des possibilités :

L’architecture Big Data IBM Streams et Big Insights et l’intégration au SI existant

A titre d’exemple, voici l’architecture déployée pour répondre aux

besoins d’une compagnie pétrolière qui souhaite pouvoir assurer en temps

réel le contrôle de ses installations et la gestion du risque :

Exemple de mise en œuvre de la plateforme IBM Big Data pour une entreprise du secteur pétrolier

Cloud et Stockage, supports incontournables du Big Data (ou pas …)

La dernière partie de la matinée était dédiée à la présentation des offres de Cloud et de stockage qui sous-tendent les architectures Big Data. S’il est vrai que sans stockage, il n’y a pas de Big Data possible, je réagis ici au fait que l’on ne peut pas résumer Big Data à une problématique de stockage. Le stockage distribué, la redondance, les mécanismes de cache pour accélérer la restitution des données, oui. Mais Big Data demande des composants d’acquisition et de qualification des données, une analyse de flux temps réel – le Stream – des briques Datawarehouse – le Rest – autant de composants que les seules solutions de stockage aussi évoluées soient-elles ne proposent pas.De même, s’il est important de disposer de données maîtres qualifiées, gérées, non redondantes pour alimenter son système Big Data, on ne peut se contenter d’une solution MDM – Master Data Management – pour assurer les traitements requis. La briques MDM est une brique à prendre en compte, ce n’est pas la seule.

En conclusion

Au final, cette matinée a permis de mettre en évidence quelques problématiques majeures associées à Big Data :- le besoin de prendre en compte des données dont on ne maitrise pas nécessairement tous les paramètres encore,

- le besoin de prendre en compte ces données dès maintenant,

- le fait que Big Data concerne un peu tout le monde et que c’est une évolution naturelle,

- la possibilité mentionnée par certains que Big Data soit l’infrastructure unique de production dans les années à venir au détriment des architectures aujourd’hui considérées comme traditionnelles.

Pour en savoir plus sur Big Data, je vous recommande vivement la lecture de l’ouvrage intitulé « Understanding Big Data« , offert en libre téléchargement (via formulaire) sur le site d’IBM. Si vous préférez acquérir une version papier : Understanding Big Data chez Amazon pour 18 euros environ.

Lire la suite :

- Qu’est-ce que Big Data ?

- Big Data version 1956 : à quoi ressemblaient 5Mb de données

- Information Management: gérer, intégrer, analyser et gouverner les données

- Retour sur le Forum Intégration et Gouvernance de l’Information

- Acquisition de Netezza, l’analytique au service de la gestion de l’information

- Forum Intégration et Gouvernance de l’Information 2011 – Live sur Twitter

- Business Intelligence, ECM et données non structurées

- 4 livres sur le Cloud Computing, la fonction RSSI, l’architecture IT et la Gestion de projets

- Quelle évolution pour la Gestion de l’Information, vers de nouvelles formes d’Intelligence

- Culture Cloud 2011, 7 Juillet – Paris

Aucun commentaire:

Enregistrer un commentaire