A lire sur: http://www.cio-online.com/actualites/lire-printemps-de-l-usf-le-big-data-explique-en-detail-4224.html?utm_source=mail&utm_medium=email&utm_campaign=Newsletter

Edition du 22/03/2012 - par Maryse Gros

Le vent des Big Data a soufflé aussi sur le Printemps de l'USF. Mardi matin, le club des utilisateurs SAP francophones s'est penché sur le sujet, tandis que les grands fournisseurs IT sortent l'un après l'autre des solutions dans ce domaine. Invité à en parler devant les adhérents, le Gartner a évoqué les multiples formes que prendrait l'exploitation de cette avalanche de données. Mais il n'existe pas de solution miracle.

Claude Molly-Mitton, président de l'USF, a invité différents

intervenants à exposer la réalité et les enjeux des Big Data aux

utilisateurs de SAP, cette semaine à Paris. Le club francophone compte

aujourd'hui 2 700 adhérents, soit une progression d'environ 13% en 2011

du nombre de membres et de sociétés représentées. L'association a prévu

de réactiver son livre blanc sur les bonnes pratiques de la relation

commerciale avec l'éditeur, co-écrit avec le Cigref. « Il sera mis à

jour pour la prochaine Convention USF qui se tiendra à Dijon les 3 et 4

octobre prochains », leur a annoncé le président. Un autre livre blanc

sur Solution Manager est également planifié. Au cours de l'après-midi,

le Printemps de l'USF avait programmé des groupes de travail sur les

applications SAP. Deux étaient ouverts à tous, adhérents ou non, celui

de la Commission PME Ile-de-France et celui sur la norme 4DS.

Pour ce Printemps, le choix des Big Data au menu de l'USF se justifie par les applications que leur traitement permet d'envisager, « impensables jusque-là », a souligne Claude Molly-Mitton pour qui il ne s'agit en aucun cas, « d'un thème marketing ou médiatique ». Cinq orateurs se sont tour à tour exprimés, envisageant différents aspects du sujet. Parmi eux, le DSI de La Poste (90 millions de tris quotidiens sur le courrier) a présenté son projet.

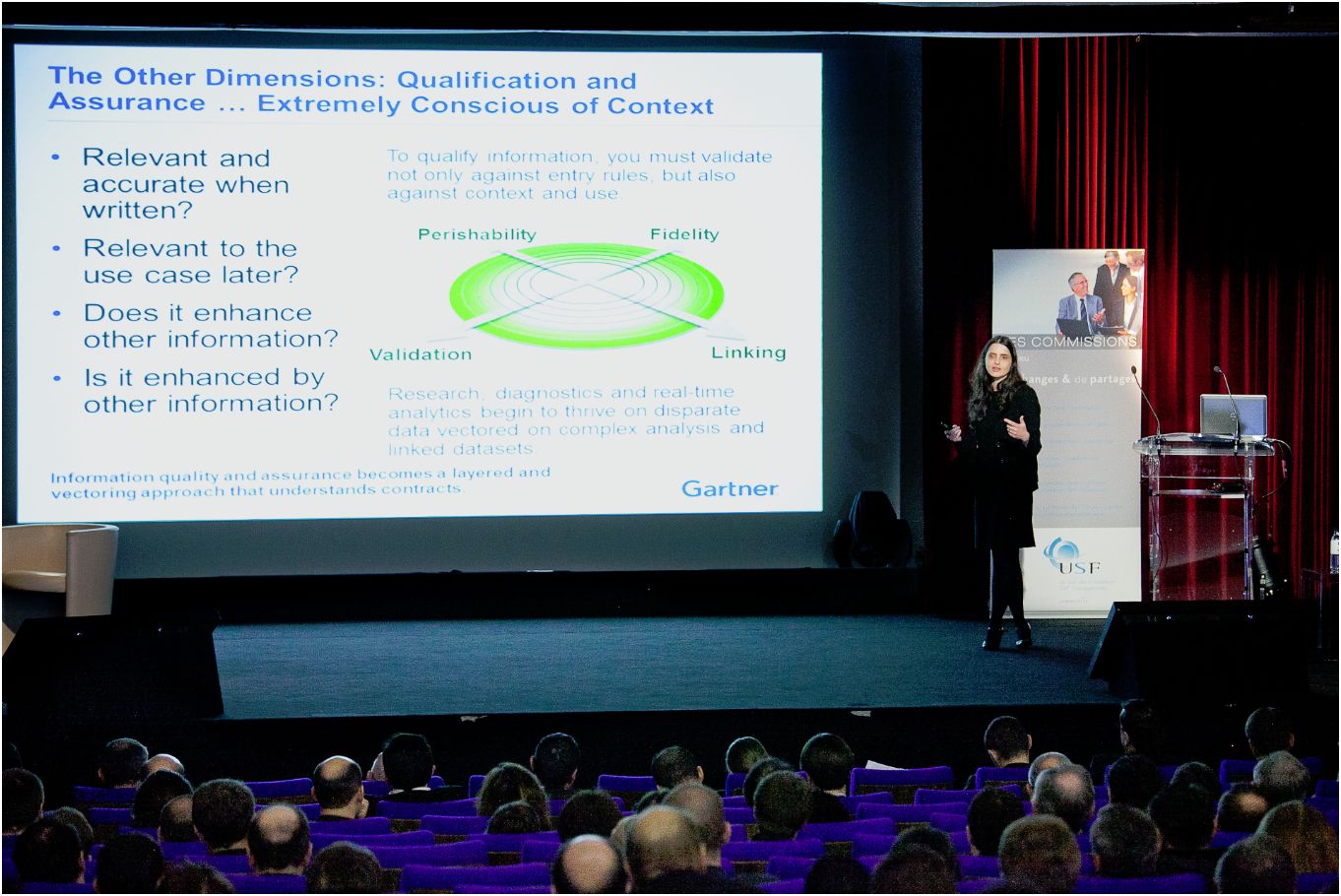

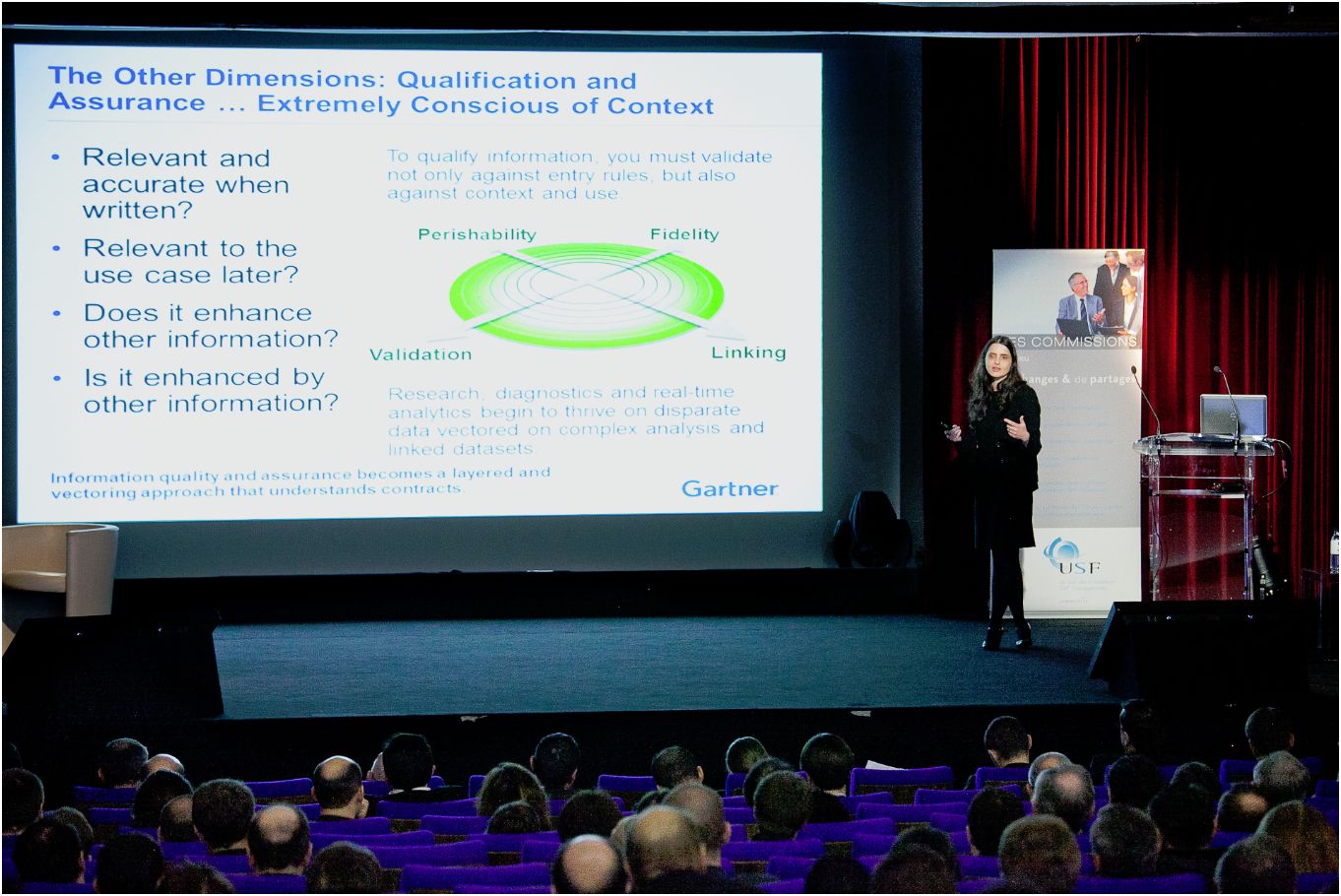

Roxane Edjlali, directeur de recherche au cabinet Gartner a livré une approche globale de la question. « Le pilier de cette problématique, ce sont les données que l'on continue à accumuler », a-t-elle rappelé. Elles sont collectées par les sites web, les réseaux sociaux, les téléphones mobiles et la géolocalisation, mais aussi par la télémétrie, la RFID et les multiples sondes et capteurs posés ici et là. « C'est une réalité. On peut choisir de l'ignorer ou de s'en servir. Chez Gartner, nous pensons qu'utiliser ces données de façon cohérente sera plutôt un avantage concurrentiel pour les entreprises ». Si ces informations sont valorisables, elles auront un impact sur leur stratégie.

La volumétrie n'est qu'un des aspects

Pour le cabinet d'études, « les organisations qui seront capables d'intégrer la diversité de ces données vont dégager d'ici 2015 une compétitivité financière supérieure de 20% à celles de leurs pairs ». Les utilisations seront cependant très diverses et prendront de nombreuses formes, a précisé l'analyste en rappelant que 60 à 80% des informations d'une entreprise étaient non structurées. « 1,2 zettaoctets de données IT ont été générés dans le monde en 2010, soit autant que depuis le début de l'informatique », a mentionné un peu plus tard François Stéphan, directeur délégué du CRIP, le club des responsables d'infrastructure et de production. « Des données qui résultent de la numérisation de notre économie, a-t-il rappelé, qui vont en outre plus que doubler tous les deux ans et que l'on ne peut pas traiter avec les outils classiques. »

Le phénomène Big Data ne borne pas à un problème de volumétrie. Loin s'en faut. « Ce n'est qu'un des aspects. Il y a aussi la vélocité des données. Elles peuvent être mesurées en temps réel avec peu de latence, par exemple avec les capteurs, ou bien arriver sous la forme de pics soudains, sur Twitter notamment », explique l'analyste. A cela s'ajoute la variété de l'information recueillie (images, vidéos, textes...) et sa complexité. « Beaucoup de ces données sont externes à l'entreprise qui a peu de pouvoir pour les gérer ou les nettoyer ». L'aspect qualitatif diffère ici sensiblement par rapport aux données transactionnelles qui sont associées à des principes de gouvernance.

L'infrastructure IT impactée sur douze axes

Dans son ensemble, le phénomène Big Data « va affecter votre infrastructure sur douze axes », a expliqué Roxane Edjlali aux adhérents de l'USF (*). Aux quatre déjà cités (volume, vélocité, variété, complexité), elle ajoute la périssabilité des informations : « Combien de temps va-t-on les garder ? » Les données doivent aussi être corrélées, reliées à d'autres qui les enrichissent. « Cela fait partie de la qualification de l'information. Si on ne peut pas relier l'information à d'autres, est-elle bien utile ? », pointe Roxane Edjlali. Elle cite encore tous les aspects juridiques sur la rétention de l'information, questions abordées un peu plus tôt dans la matinée par Maître Christiane Feral-Schuhl, avocate spécialisée en nouvelles technologies. Cette dernière avait aussi largement évoqué la démarche Open Data qui conduit à l'ouverture des données publiques, celles-ci pouvant dès lors être corrélées avec d'autres informations.

Crédit photo : Nicolas Fagot

Edition du 22/03/2012 - par Maryse Gros

Le vent des Big Data a soufflé aussi sur le Printemps de l'USF. Mardi matin, le club des utilisateurs SAP francophones s'est penché sur le sujet, tandis que les grands fournisseurs IT sortent l'un après l'autre des solutions dans ce domaine. Invité à en parler devant les adhérents, le Gartner a évoqué les multiples formes que prendrait l'exploitation de cette avalanche de données. Mais il n'existe pas de solution miracle.

Pour ce Printemps, le choix des Big Data au menu de l'USF se justifie par les applications que leur traitement permet d'envisager, « impensables jusque-là », a souligne Claude Molly-Mitton pour qui il ne s'agit en aucun cas, « d'un thème marketing ou médiatique ». Cinq orateurs se sont tour à tour exprimés, envisageant différents aspects du sujet. Parmi eux, le DSI de La Poste (90 millions de tris quotidiens sur le courrier) a présenté son projet.

Roxane Edjlali, directeur de recherche au cabinet Gartner a livré une approche globale de la question. « Le pilier de cette problématique, ce sont les données que l'on continue à accumuler », a-t-elle rappelé. Elles sont collectées par les sites web, les réseaux sociaux, les téléphones mobiles et la géolocalisation, mais aussi par la télémétrie, la RFID et les multiples sondes et capteurs posés ici et là. « C'est une réalité. On peut choisir de l'ignorer ou de s'en servir. Chez Gartner, nous pensons qu'utiliser ces données de façon cohérente sera plutôt un avantage concurrentiel pour les entreprises ». Si ces informations sont valorisables, elles auront un impact sur leur stratégie.

La volumétrie n'est qu'un des aspects

Pour le cabinet d'études, « les organisations qui seront capables d'intégrer la diversité de ces données vont dégager d'ici 2015 une compétitivité financière supérieure de 20% à celles de leurs pairs ». Les utilisations seront cependant très diverses et prendront de nombreuses formes, a précisé l'analyste en rappelant que 60 à 80% des informations d'une entreprise étaient non structurées. « 1,2 zettaoctets de données IT ont été générés dans le monde en 2010, soit autant que depuis le début de l'informatique », a mentionné un peu plus tard François Stéphan, directeur délégué du CRIP, le club des responsables d'infrastructure et de production. « Des données qui résultent de la numérisation de notre économie, a-t-il rappelé, qui vont en outre plus que doubler tous les deux ans et que l'on ne peut pas traiter avec les outils classiques. »

Le phénomène Big Data ne borne pas à un problème de volumétrie. Loin s'en faut. « Ce n'est qu'un des aspects. Il y a aussi la vélocité des données. Elles peuvent être mesurées en temps réel avec peu de latence, par exemple avec les capteurs, ou bien arriver sous la forme de pics soudains, sur Twitter notamment », explique l'analyste. A cela s'ajoute la variété de l'information recueillie (images, vidéos, textes...) et sa complexité. « Beaucoup de ces données sont externes à l'entreprise qui a peu de pouvoir pour les gérer ou les nettoyer ». L'aspect qualitatif diffère ici sensiblement par rapport aux données transactionnelles qui sont associées à des principes de gouvernance.

L'infrastructure IT impactée sur douze axes

Dans son ensemble, le phénomène Big Data « va affecter votre infrastructure sur douze axes », a expliqué Roxane Edjlali aux adhérents de l'USF (*). Aux quatre déjà cités (volume, vélocité, variété, complexité), elle ajoute la périssabilité des informations : « Combien de temps va-t-on les garder ? » Les données doivent aussi être corrélées, reliées à d'autres qui les enrichissent. « Cela fait partie de la qualification de l'information. Si on ne peut pas relier l'information à d'autres, est-elle bien utile ? », pointe Roxane Edjlali. Elle cite encore tous les aspects juridiques sur la rétention de l'information, questions abordées un peu plus tôt dans la matinée par Maître Christiane Feral-Schuhl, avocate spécialisée en nouvelles technologies. Cette dernière avait aussi largement évoqué la démarche Open Data qui conduit à l'ouverture des données publiques, celles-ci pouvant dès lors être corrélées avec d'autres informations.

Crédit photo : Nicolas Fagot

Aucun commentaire:

Enregistrer un commentaire